HBM(High Bandwidth Memory,高带宽内存)是一种基于3D堆叠技术的高性能动态随机存取存储器(DRAM),通过硅通孔(TSV)和微凸块(Microbump)将多个DRAM芯片垂直堆叠,并与处理器(如GPU、AI加速芯片)通过硅中介层(Interposer)实现近距离高速互连。

相比传统GDDR6内存,HBM具有更高的内存带宽、更低的功耗和更小的物理占用面积,是当前AI训练、高性能计算(HPC)和数据中心GPU的核心配套存储技术。

HBM的带宽可达1TB/s以上(如HBM3E),远超GDDR6的约800GB/s,同时功耗降低约30%。

目前主流版本包括HBM2、HBM2E、HBM3和正在推进的HBM3E,下一代HBM4预计2026年后量产,带宽将突破2TB/s。

其典型应用场景包括英伟达H100、AMD MI300X、华为昇腾910B等AI加速芯片,是支撑大模型训练与推理的关键底层技术之一。

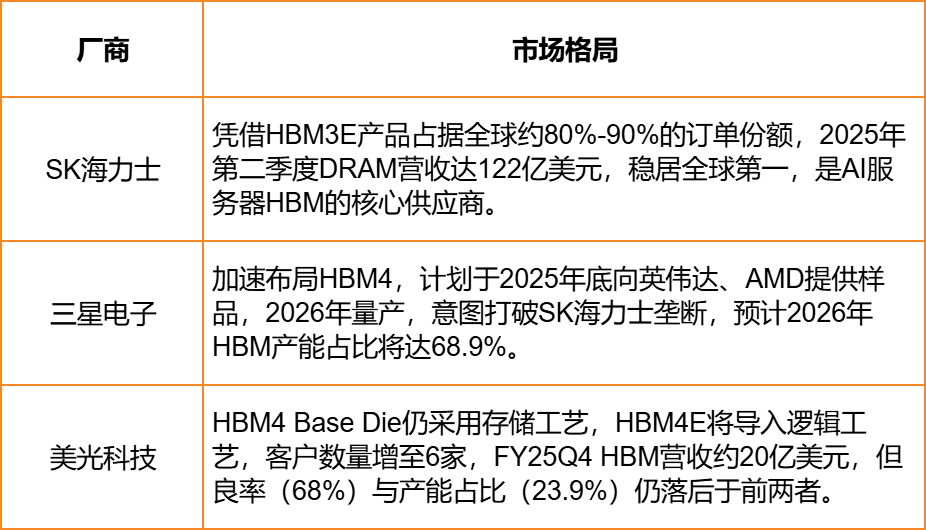

全球市场格局

HBM市场由SK海力士、三星电子和美光科技主导。

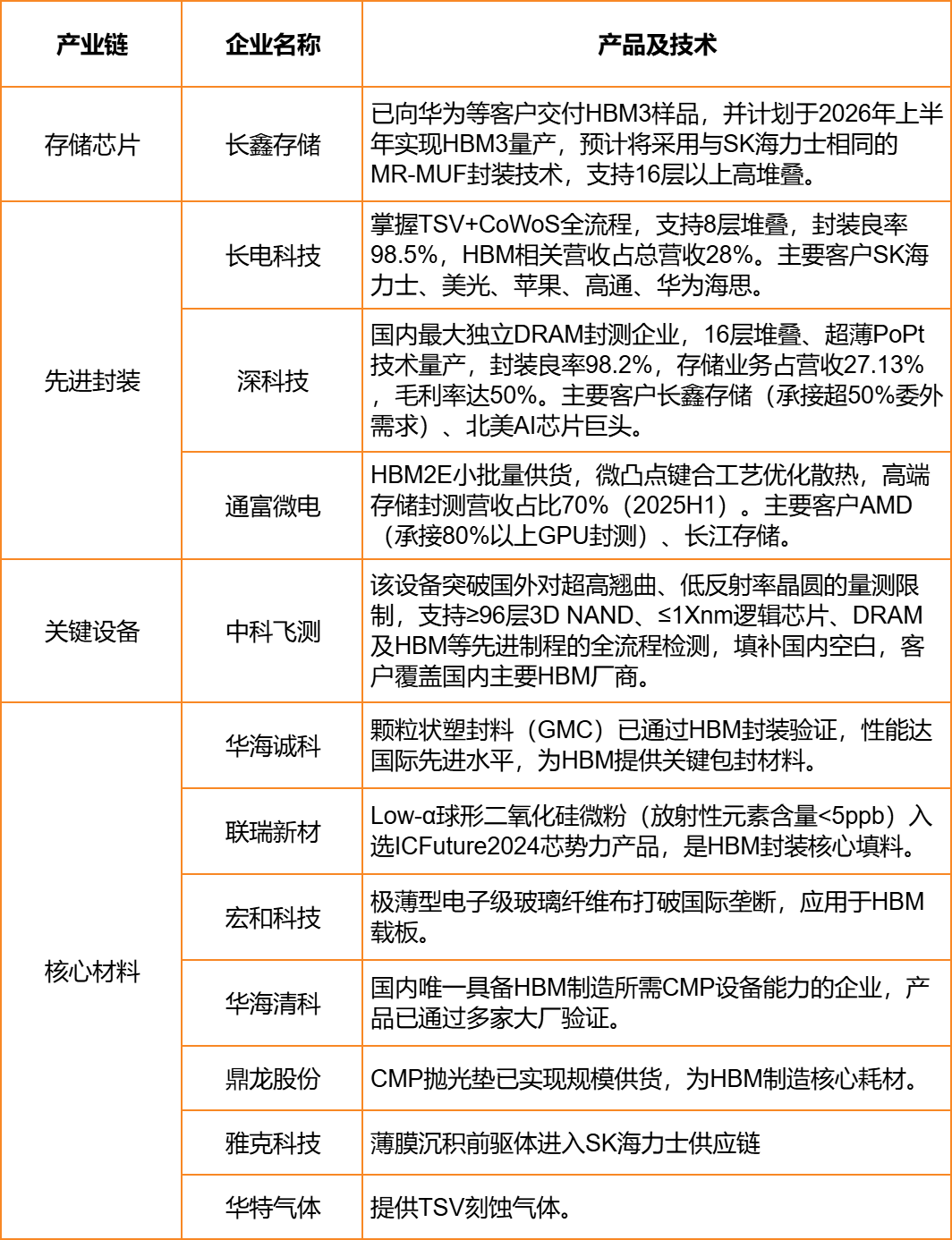

国内相关企业

风险提示:以上内容仅供参考,不构成投资建议。